夕小瑶科技说 原创作者 | 小戏、ZenMoore

要说现在 GPT-4 最大的问题是什么?可能除了一时拿他没有办法的机器幻觉,就是卡死的输入长度了吧。尽管在一般的对话、搜索的场景里目前普通版本 GPT-4 的 8000 左右的上下文长度或许绰绰有余,但是在诸如内容生成、智能阅读等方面当下基础版的 GPT-4 还是有些捉襟见肘。

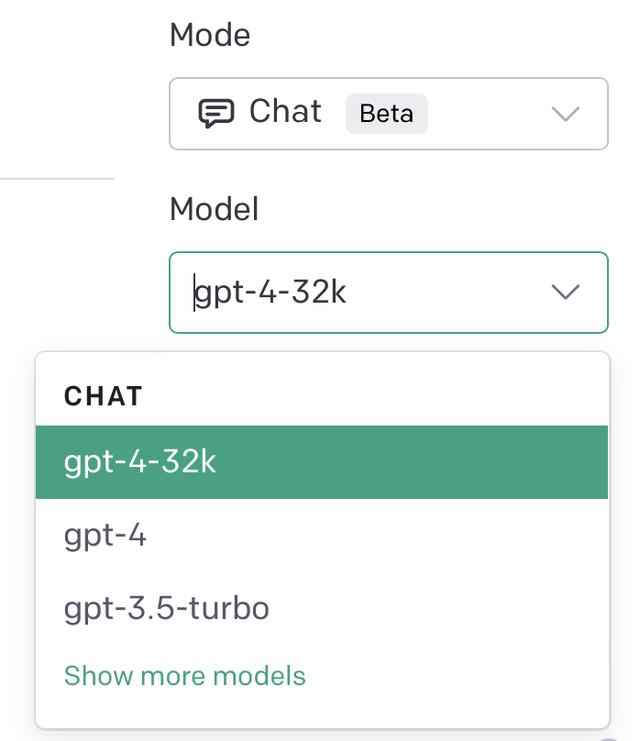

然而在 GPT-4 的发布会里也谈到,事实上 GPT-4 是支持 32768 个 token 长度的,只是暂时还没有被完全释放,而是会陆续自动更新。而这两天,32k GPT-4 的曙光似乎马上就要来了!不少 GPT-4 的用户已经可以在自己的 PlayGround 上看到 GPT-4 32k 的选项。

在 API 里,也可以通过指定 GPT-4-32K 的 Model 来对升级版进行调用

当然,不管怎样,32k 的 GPT-4 看起来确实是离我们越来越近了,那么 32k 的 GPT-4 会带来什么样的想象力的改变呢?毕竟它的价格比 8k 版本的 GPT-4 贵了两倍,并且有可能会有更慢的响应时间……

在 OpenAI 之外,也有开源模型开放了甚至更大上下文长度的大规模语言模型。这个名为 MPT-7B (也称做 Llongboi) 在这个月 5 号发布,这个花费了 20 万美元训练的 Llongboi 最大的亮点在于支持 64k 的上下文,可以服务于内容生成、聊天等多种场景。

当然,开源项目的性能及稳定性肯定无法比肩 GPT-4,既然已经陆陆续续开始有人收到了 32k 的 GPT-4 的邀请,相信它必然很快就会和我们见面,那就让我们“Hopefully it picks up the pace”吧!

相关文章

猜你喜欢