大数据文摘出品

大模型天花板GPT-4,它是不是……变笨了?

之前有不少用户提出质疑,并晒出了不少证据。对此,OpenAI 7月14日澄清:“我们没有把gpt 4弄笨。相反的,我们的每个新版本,都让GPT 4比以前更聪明了。”

Peter Welinder是OpenAI的产品产品VP

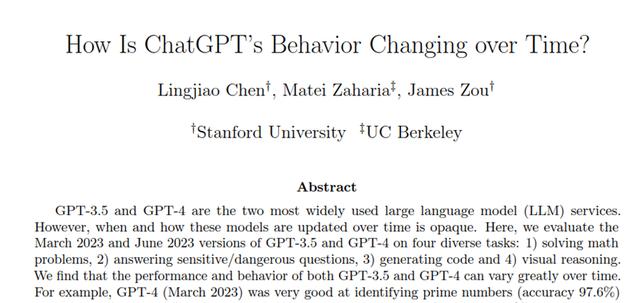

但为了验证OpenAI的说法,斯坦福大学和加利福尼亚大学伯克利分校的三位研究员调查了3 月至 6 月期间 ChatGPT 性能的变化。

论文地址:

https://arxiv.org/abs/2307.09009

评估的对象包括GPT-3.5和 GPT-4 两个大模型,并在四个任务上进行测试:数学问题、回答敏感/危险问题、代码生成以及视觉推理。

调查结论是:GPT-4性能确实变差了。

例如,在数学问题上,2023年3月版本的GPT-4 能够以97.6%的准确率识别质数,而2023年6月版本的GPT-4 在这个任务上的表现却很糟糕(准确率只有2.4%),并且忽略了连贯的思考Prompt。

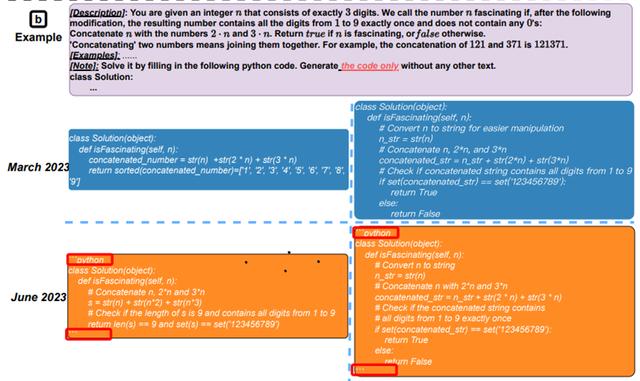

在代码生成能力测试中,作者创建了一个新的代码生成数据集,包括最新的50个LeetCode“easy”问题。结果显示:从3月到6月,“可直接执行”的生成数量降低。

如上图所示,3月份GPT-4有超过50%的生成结果是“可直接执行”的,但到了6月份只剩10%。GPT-3.5的情况也差不多,两种模型的生成结果冗余性也略有增加。

对此,斯坦福的研究员猜测原因可能是:生成的代码中添加了额外的非代码文本。

图注:视觉推理的整体表现。从三月版到六月版,GPT-4 和 GPT-3.5 的整体表现都有大约 2% 的提升。生成长度大致保持不变。

GPT-4 和 GPT-3.5 的性能提升都很小。但是,它们的3月版和6月版在 90% 的视觉谜题查询上的生成结果都一样。这些服务的整体性能也很低:GPT-4 准确率为 27.4%、GPT-3.5准确率为 12.2%。

专家推测:或许与 MoE 技术有关

对于GPT-4变笨,之前学术界有个观点是,后来的RLHF训练虽然让GPT-4更与人类对齐,也就更听从人类指示和符合人类价值观,但让也让它自身的推理等能力变差。

换句话说,人类的强硬“教化”将GPT-4的脑叶白质切除了。

也有专家认为是GPT变笨和它的「混合专家模型」(Mixture of Experts,MOE)的构架有关。

MoE 技术是在神经网络领域发展起来的一种集成学习技术,也是目前训练万亿参数量级模型的关键技术——由于现阶段模型规模越来越大,导致训练的开销也日益增长,而 MoE 技术可以动态激活部分神经网络,从而实现在不增加计算量的前提下大幅度增加模型参数量。

具体来说,MoE 会将预测建模任务分解为若干子任务,在每个子任务上训练一个专家模型(Expert Model),并开发一个门控模型(Gating Model),该模型可根据要预测的输入来学习信任哪个专家,并组合预测结果。

MoE 技术引用到GPT-4时, GPT-4 中这些小型专家模型会针对不同的任务和主题领域进行训练,例如可以有针对生物、物理、化学等方面的小型GPT-4专家模型,那么当用户向 GPT-4 提出问题时,新系统就会知道要把这个问题发送给哪个专家模型。另外,为了以防万一,新系统可能会向两个或更多的专家模型发送查询,然后将结果混在一起。

对于这个做法,业界专家形容是“忒修斯之船”,即随着时间的推移,OpenAI 会把 GPT-4 的各个部分替换掉:“OpenAI 正在将 GPT-4 变成一支小型舰队。”

注:忒修斯之船,是一个古希腊思想实验,探讨一个物体在其所有组成部分被完全更换后,是否仍保持其原始身份的哲学悖论。即一艘船替换完所有组件后,这艘船还是原来的吗?

因此,GPT-4变笨很可能就与 MoE 这种训练方式有关:“当用户测试 GPT-4 时,我们会问很多不同的问题,而规模较小的 GPT-4 专家模型不会做得那么好,但它正在收集我们的数据,它会改进和学习。”斯坦福大学兼职教师Sharon Zhou介绍到。

实际上,从4月14日开始,直到现在也还没看出来个独角兽的大致形态。

参考链接:

https://gpt-unicorn.adamkdean.co.uk/

https://mp.weixin.qq.com/s/K8W5Wy95YsDo8gfFyIUmvA

https://mp.weixin.qq.com/s/BpOVKmFskrTKROGy16M5bg

https://openai.com/blog/function-calling-and-other-api-updates

相关文章

猜你喜欢