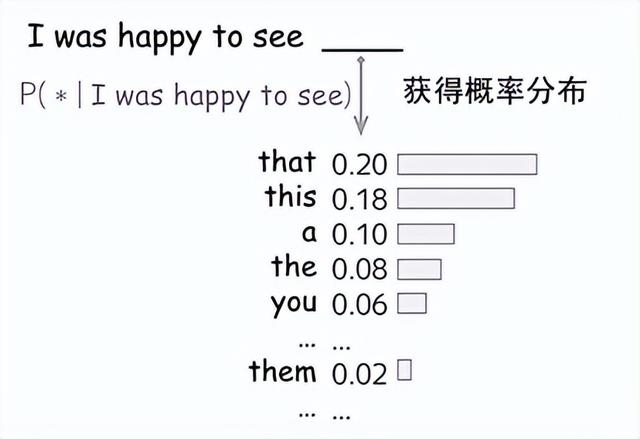

训练数据量是一个非常重要的因素。

本轮AI的技术革命有两个非常明显的特征:

1、天花板非常明确:现有的训练方式无法训练出强人工智能,也就是说,科幻作品中看到的那些具有自主意识的AI,本轮是看不到了。

2、代价非常明确:要想得到好的训练效果,需要大量的数据。

最近火出圈的无论是novelAI,还是ChatGPT,都建立在大量喂数据的基础上。

而国内用于训练的数据量,是远远不足的。

一方面,中文的数字化资料在体量上就低于英文的数字化资料一个数量级。

另一方面,则是因为审查的原因。

国内的审查边界比较模糊,很多时候不知道触犯了什么规则,安全起见文字内容就被审查了,这其实降低了中文数字信息的信息量。

对于AI而言,你无法用不存在的训练集,告诉它什么不该说,它因此也不知道什么该说。

比如,如何让AI正常讨论社会主义核心价值观里那两条比较敏感的内容,同时不触碰审查边界?

最终的结果很可能是这样的:

填写图片摘要(选填)

填写图片摘要(选填)

当然,这仅仅是国内AI技术在通用场景的大模型上存在的限制,在一些特定场景的小模型上,比如智能客服回复等,上述劣势并不明显,还是有很多做好的的机会的。

相关文章

猜你喜欢