编辑:桃子 好困

【新智元导读】由普林斯顿和谷歌DeepMind联合提出的全新「思维树」框架,让GPT-4可以自己提案、评估和决策,推理能力最高可提升1750%。2022年,前谷歌大脑华人科学家Jason Wei在一篇思维链的开山之作中首次提出,CoT可以增强LLM的推理能力。

但即便有了思维链,LLM有时也会在非常简单的问题上犯错。

最近,来自普林斯顿大学和Google DeepMind研究人员提出了一种全新的语言模型推理框架——「思维树」(ToT)。

ToT将当前流行的「思维链」方法泛化到引导语言模型,并通过探索文本(思维)的连贯单元来解决问题的中间步骤。

这个观点突出了现有使用LLM解决通用问题方法的2个主要缺点:

1. 局部来看,LLM没有探索思维过程中的不同延续——树的分支。

2. 总的来看,LLM不包含任何类型的计划、前瞻或回溯,来帮助评估这些不同的选择。

为了解决这些问题,研究者提出了用语言模型解决通用问题的思维树框架(ToT),让LLM可以探索多种思维推理路径。

ToT四步法

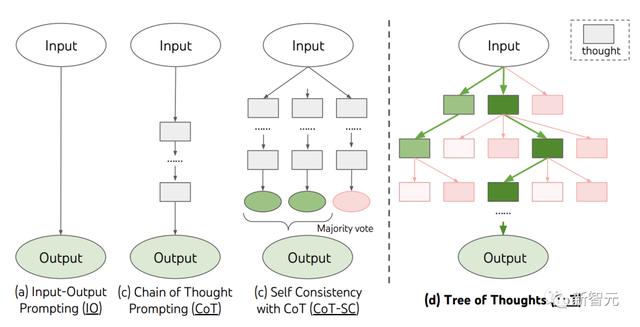

当前,现有的方法,如IO、CoT、CoT-SC,通过采样连续的语言序列进行问题解决。

而ToT主动维护了一个「思维树」。每个矩形框代表一个思维,并且每个思维都是一个连贯的语言序列,作为解决问题的中间步骤。

导致多样性时,效果更好。

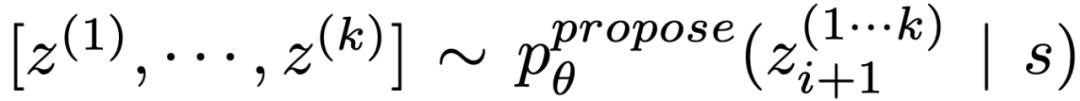

(b)使用「proposal prompt」按顺序提出想法:

给定不同状态的前沿,状态评估器评估它们解决问题的进展,作为搜索算法的启发式算法,以确定哪些状态需要继续探索,以及以何种顺序探索。

虽然启发式算法是解决搜索问题的标准方法,但它们通常是编程的(DeepBlue)或学习的(AlphaGo)。这里,研究者提出了第三种选择,通过LLM有意识地推理状态。

在适用的情况下,这种深思熟虑的启发式方法可以比程序规则更灵活,比学习模型更有效率。与思维生成器,研究人员也考虑2种策略来独立或一起评估状态:对每个状态独立赋值;跨状态投票。

4. 搜索算法

最后,在ToT框架中,人们可以根据树的结构,即插即用不同的搜索算法。

研究人员在此探索了2个相对简单的搜索算法:

算法1——广度优先搜索(BFS),每一步维护一组b最有希望的状态。

算法2——深度优先搜索(DFS),首先探索最有希望的状态,直到达到最终的输出

由上,LLM通过自我评估和有意识的决策,来实现启发式搜索的方法是新颖的。

实验

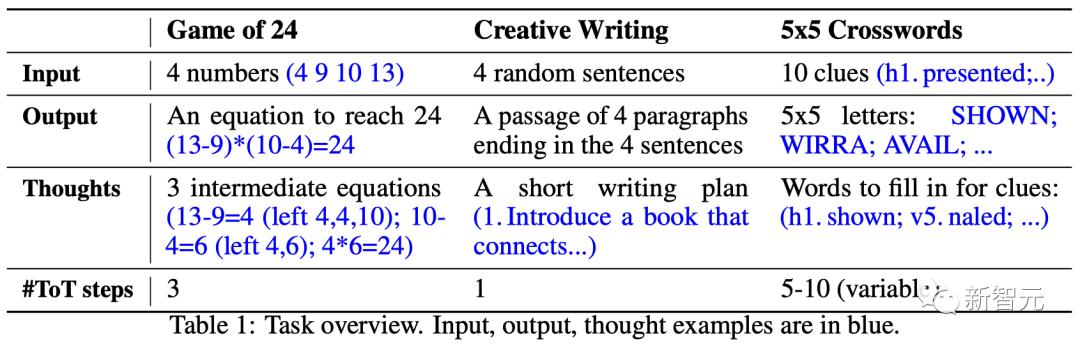

为此,团队提出了三个任务用于测试——即使是最先进的语言模型GPT-4,在标准的IO提示或思维链(CoT)提示下,都是非常富有挑战的。

ToT设置

团队利用深度优先搜索保持探索最有可能成功的后续单词线索,直到状态不再有希望,然后回溯到父状态以探索替代的思维。

为了使搜索可行,后续的思维被限制不改变任何已填写的单词或字母,这样ToT最多有10个中间步骤。

对于思维生成,团队在每个状态下将所有现有的思维(例如,「h2.motor; h1.tasks」对于图6(a)中的状态)转换为剩余线索的字母限制(例如,「v1.To heap: tm___;...」),从而得到下一个单词填写位置和内容的候选。

重要的是,团队也提示LLM给出不同思维的置信度,并在提案中汇总这些以获得下一个要探索的思维的排序列表(图6(a))。

对于状态评估,团队类似地将每个状态转换为剩余线索的字母限制,然后评估每个线索是否可能在给定限制下填写。

如果任何剩余的线索被认为是「不可能」的(例如,「v1. To heap: tm_s_」),那么该状态的子树的探索就被剪枝,并且DFS回溯到其父节点来探索下一个可能的候选。

结果

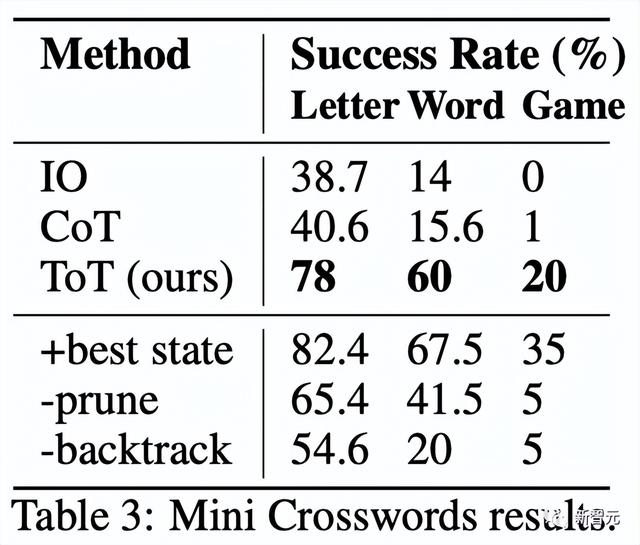

如表3所示,IO和CoT的提示方法在单词级成功率上表现不佳,低于16%,而ToT显著改善了所有指标,实现了60%的单词级成功率,并解决了20个游戏中的4个。

鉴于IO和CoT缺乏尝试不同线索、改变决策或回溯的机制,这种改善并不令人惊讶。

局限性与结论ToT是一个让LLM可以更自主、更智能地做决策和解决问题的框架。

它提高了模型决策的可解释性以及与人类对齐的机会,因为ToT所生成的表征表形式是可读的、高级的语言推理,而不是隐式的、低级的token值。

对于那些GPT-4已经十分擅长的任务来说,ToT可能并是不必要的。

此外,像ToT这样的搜索方法需要更多的资源(如GPT-4 API成本)来提高任务性能,但ToT的模块化灵活性让用户可以自定义这种性能-成本平衡。

不过,随着LLM被用于更多真实世界的决策应用(如编程、数据分析、机器人技术等),ToT可以为研究那些即将出现的更为复杂的任务,提供新的机会。

作者介绍

Shunyu Yao(姚顺雨)

论文一作Shunyu Yao是普林斯顿大学的四年级博士生,此前毕业于清华大学的姚班。

他的研究方向是在语言智能体与世界之间建立互动,例如玩文字游戏(CALM),网上购物(WebShop),浏览维基百科进行推理(ReAct),或者,基于同样的想法,用任何工具来完成任何任务。

在生活中,他喜欢阅读、篮球、台球、旅行和说唱。

Dian Yu

Dian Yu是Google DeepMind的一名研究科学家。此前,他在加州大学戴维斯分校获得了博士学位,并在纽约大学获得了学士学位,双主修计算机科学和金融(还有一点表演)。

他的研究兴趣是语言的属性表征,以及多语言和多模态的理解,主要专注于对话研究(包括开放领域和任务导向)。

Yuan Cao

Yuan Cao也是Google DeepMind的一名研究科学家。此前,他在上海交通大学获得了学士和硕士学位,并在约翰斯·霍普金斯大学获得了博士学位。还曾担任过百度的首席架构师。

Jeffrey Zhao

Jeffrey Zhao是Google DeepMind的软件工程师。此前,他在卡内基梅隆大学获得了学士和硕士学位。

参考资料:

相关文章

猜你喜欢

成员 网址收录40406 企业收录2984 印章生成243018 电子证书1087 电子名片62 自媒体71458