机器之心报道

编辑:杜伟、陈萍

来自 Facebook AI 的研究者提出了 NormFormer,该模型能够更快地达到目标预训练的困惑度,更好地实现预训练困惑度和下游任务性能。

在原始的 Transformer 架构中,LayerNorm 通常在 Residual 之后,称之为 Post-LN(Post-Layer Normalization)Transformer,该模型已经在机器翻译、文本分类等诸多自然语言的任务中表现突出。

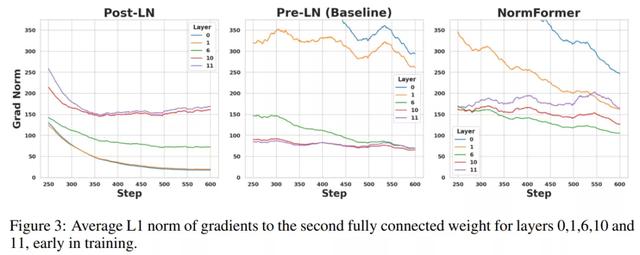

最近的研究表明,在 Post-LN transformer 中,与较早层的网络相比,在较后层的网络中具有更大的梯度幅度。

实践表明,Pre-LN Transformer 可以使用更大的学习率、极小的学习率进行预热(即 warm-up),并且与 Post-LN Transformer 相比通常会产生更好的性能,所以最近大型预训练语言模型倾向于使用 Pre-LN transformer。

来自 Facebook AI 的研究者表明,虽然 Pre-LN 比 Post-LN 提高了稳定性,但也具有缺点:较早层的梯度往往大于较后层的梯度。这些问题可以通过该研究提出的 NormFormer 来缓解,它通过向每一层添加 3 个归一化操作来缓解梯度幅度不匹配问题(见图 1,中间):自注意力之后添加层归一,自注意力输出的 head-wise 扩展,在第一个全连接层之后添加层归一。这些操作减少了早期层的梯度,增加了后期层的梯度,使不同层的梯度大小更接近。

此外,这些额外的操作产生的计算成本可以忽略不计( 0.4% 的参数增加),但这样做可以提高模型预训练困惑度和在下游任务的表现,包括在 1.25 亿参数到 27 亿参数的因果模型和掩码语言模型的性能。例如,该研究在最强的 1.3B 参数基线之上添加 NormFormer 可以将同等困惑度提高 24%,或者在相同的计算预算下更好地收敛 0.27 倍困惑度。该模型以快 60% 的速度达到了与 GPT3-Large (1.3B)零样本相同的性能。对于掩码语言模型,NormFormer 提高了微调好的 GLUE 性能,平均提高了 1.9%。

来自魁北克蒙特利尔学习算法研究所的机器学习研究者 Ethan Caballero 表示:「更多的归一化 is All You Need,在 GPT-3 架构中使用 NormFormer 达到了 SOTA 性能, 速度提高了 22%,并在下游任务中获得了更强的零样本性能。」

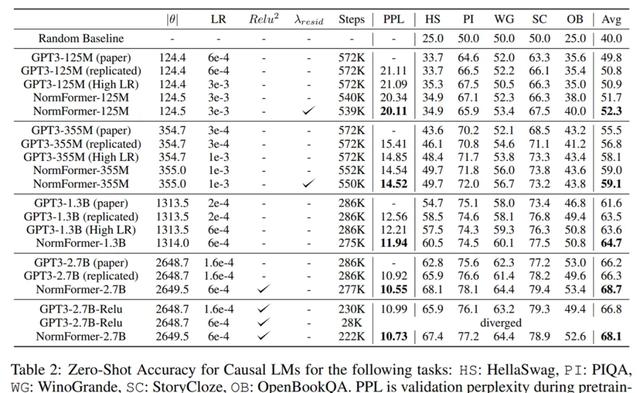

研究者在下游任务上也观察到了类似的趋势。如下表 2 所示,研究者使用 Brown et al. (2020)中的任务和 prompt 来观察 CLM 模型的零样本准确率。同样地,NormFormer 在所有大小上均优于 GPT-3。

对于 MLM 模型,研究者在下表 3 中报告了在 GLUE 上的微调准确率。再次,NormFormer MLM 模型在每个任务上都优于它们的 Pre-LN 模型。

为了度量架构的稳定性,研究者使用具有极大峰值学习率的学习率计划对其进行训练,使得学习率每个 step 增加一点,直到损失爆炸。图 5 显示了与基线相比,NormFormer 模型在此环境中可以承受更多的更新。

相关文章

猜你喜欢